Các nhà nghiên cứu tại DeepSeek đã công bố một mô hình thử nghiệm mới có tên V3.2-exp, được thiết kế để giảm đáng kể chi phí suy luận khi sử dụng trong các phép toán ngữ cảnh dài.

DeepSeek đã công bố mô hình này trong một bài đăng trên Hugging Face, đồng thời đăng một bài báo học thuật có liên kết trên GitHub.

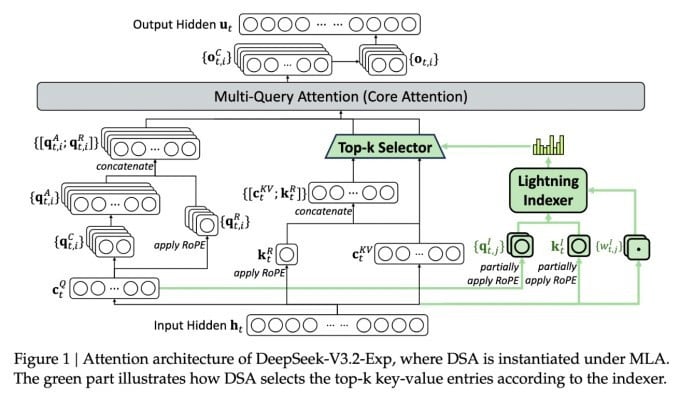

Tính năng quan trọng nhất của mô hình mới phức tạp được gọi là DeepSeek Sparse Attention. Về cơ bản, hệ thống sử dụng một mô-đun gọi là "bộ lập chỉ mục sét" để ưu tiên các đoạn trích cụ thể từ cửa sổ ngữ cảnh.

DeepSeek công bố mô hình suy luận tiết kiệm chi phí.

Sau đó, một hệ thống riêng biệt gọi là "hệ thống lựa chọn mã thông báo chi tiết" sẽ chọn các mã thông báo cụ thể từ các đoạn trích đó để tải vào cửa sổ chú ý hạn chế của mô-đun. Kết hợp lại, chúng cho phép các mô hình Sparse Attention hoạt động trên các phần ngữ cảnh dài với tải máy chủ tương đối nhỏ.

Đối với các hoạt động ngữ cảnh dài, lợi ích của hệ thống là rất đáng kể. Thử nghiệm sơ bộ của DeepSeek cho thấy chi phí của một lệnh gọi hàm suy luận (API) đơn giản có thể giảm tới một nửa trong các tình huống ngữ cảnh dài.

Cần phải thử nghiệm thêm để xây dựng một đánh giá mạnh mẽ hơn, nhưng vì mô hình này là mô hình mở và có sẵn miễn phí trên Hugging Face, nên sẽ không lâu nữa các thử nghiệm của bên thứ ba có thể đánh giá các tuyên bố trong bài báo.

Khác với các mô hình Chatbot AI khác tiêu tốn năng lượng cực lớn, DeepSeek đi theo hướng tiết kiệm chi phí đào tạo đến vận hành.

Mô hình mới của DeepSeek là một trong chuỗi đột phá gần đây giải quyết vấn đề chi phí suy luận — về cơ bản, chi phí máy chủ để vận hành một mô hình AI đã được đào tạo trước, khác với chi phí đào tạo nó.

Trong trường hợp của DeepSeek, các nhà nghiên cứu đang tìm cách làm cho kiến trúc biến áp cơ bản hoạt động hiệu quả hơn — và nhận thấy cần phải thực hiện những cải tiến đáng kể.

Có trụ sở tại Trung Quốc, DeepSeek là một nhân vật khác thường trong cơn sốt AI, đặc biệt là đối với những người coi nghiên cứu AI là cuộc cạnh tranh giữa Mỹ và Trung Quốc. Công ty đã tạo nên tiếng vang vào đầu năm với mô hình R1, được đào tạo chủ yếu bằng học tăng cường với chi phí thấp hơn nhiều so với các đối thủ cạnh tranh tại Mỹ.

Tuy nhiên, mô hình này đã không tạo ra một cuộc cách mạng toàn diện trong đào tạo AI như một số người dự đoán, và công ty đã dần rút lui khỏi sự chú ý trong những tháng sau đó.

Phương pháp "chú ý thưa thớt" mới khó có thể gây ra sự phẫn nộ như R1 — nhưng nó vẫn có thể dạy cho các nhà cung cấp dịch vụ tại Mỹ một số mẹo rất cần thiết để giúp giữ chi phí suy luận ở mức thấp.

https://techcrunch.com/2025/09/29/deepseek-releases-sparse-attention-model-that-cuts-api-costs-in-half/

Nguồn: https://khoahocdoisong.vn/deepseek-dao-tao-da-re-nay-con-co-ban-suy-luan-re-hon-post2149057353.html

![[Ảnh] Học sinh Trường tiểu học Bình Minh vui hội trăng rằm, đón nhận niềm vui tuổi thơ](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/8cf8abef22fe4471be400a818912cb85)

![[Ảnh] Thủ tướng Phạm Minh Chính chủ trì họp triển khai khắc phục hậu quả bão số 10](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/10/3/544f420dcc844463898fcbef46247d16)

![[INFOGRAPHIC] Nhìn lại những lần Chính phủ Mỹ đóng cửa](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/10/3/c467276604584d2889c0d2d84fecd986)

Bình luận (0)