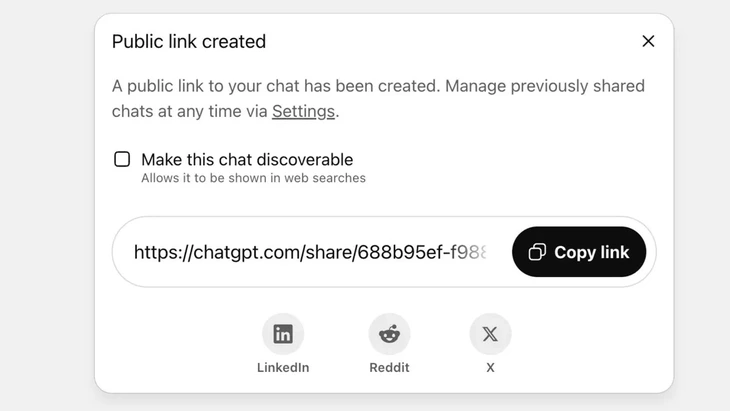

Tính năng chia sẻ đoạn chat qua liên kết công khai trên ChatGPT - Ảnh: Techradar

ChatGPT hiện đạt hơn 2,5 tỉ truy vấn từ người dùng toàn cầu mỗi ngày, cho thấy mức độ phổ biến ngày càng tăng của chatbot này.

Tuy nhiên công cụ này đang gặp phải phản ứng gay gắt từ phía người dùng, khi tính năng “chia sẻ” khiến hàng ngàn cuộc trò chuyện bị lộ lọt thông tin nhạy cảm lên Google và một số công cụ tìm kiếm trên Internet.

Tính rủi ro bảo mật ở mức cao

Ông Vũ Ngọc Sơn - trưởng ban công nghệ của Hiệp hội An ninh mạng quốc gia (NCA) - đánh giá vụ việc trên cho thấy rủi ro bảo mật ở mức cao đối với người dùng ChatGPT.

“Vụ việc trên không hẳn là một lỗ hổng kỹ thuật khi có sự chủ động nhất định của người dùng trong việc bấm nút chia sẻ. Tuy nhiên có thể nói vấn đề nằm ở khâu thiết kế sản phẩm chatbot AI, khi đã gây nhầm lẫn cho người dùng và không có những biện pháp khuyến cáo đủ mạnh về nguy cơ lộ lọt dữ liệu cá nhân nếu người dùng chia sẻ”, ông Vũ Ngọc Sơn phân tích.

Trên ChatGPT, tính năng này được thực hiện sau khi người dùng chọn chia sẻ chat qua liên kết công khai, nội dung sẽ được lưu trữ trên máy chủ của OpenAI dưới dạng trang web công khai (chatgpt.com/share/...), không yêu cầu đăng nhập hoặc mật khẩu để truy cập.

Các công cụ thu thập thông tin của Google tự động quét và đánh chỉ mục (index) những trang này, khiến chúng xuất hiện trong kết quả tìm kiếm, bao gồm cả văn bản, hình ảnh hoặc dữ liệu nhạy cảm trong chat.

Nhiều người dùng không nhận ra rủi ro này vì chỉ nghĩ rằng mình đang chia sẻ đoạn chat với bạn bè hoặc người liên quan. Điều này dẫn đến hàng nghìn cuộc trò chuyện bị lộ, với một số trường hợp chứa thông tin cá nhân nhạy cảm.

Mặc dù OpenAI đã nhanh chóng loại bỏ tính năng này vào cuối tháng 7-2025 sau phản ứng từ cộng đồng, nhưng vẫn cần thêm thời gian để phối hợp với Google để xóa các index cũ. Đặc biệt với hệ thống lưu trữ phức tạp, trong đó bao gồm cả các máy chủ tăng tốc (cache) của Google thì điều này không thể làm nhanh.

Không nên coi chatbot AI như “hộp đen an toàn”

Chuyên gia bảo mật dữ liệu Vũ Ngọc Sơn - trưởng ban công nghệ của Hiệp hội An ninh mạng quốc gia (NCA) - Ảnh: CHÍ HIẾU

Vụ việc lộ lọt hàng ngàn đoạn chat có thể gây ra những rủi ro cho người dùng như lộ bí mật cá nhân, bí mật kinh doanh; bị tổn hại danh tiếng, rủi ro tài chính hoặc thậm chí nguy hiểm về an toàn khi lộ địa chỉ nơi ở.

"Những công cụ chatbot tích hợp AI hỗ trợ hữu ích nhưng không phải là 'hộp đen an toàn', bởi dữ liệu chia sẻ có thể tồn tại vĩnh viễn trên web nếu không được kiểm soát.

Vụ việc trên chắc chắn là bài học cho cả bên cung cấp lẫn người sử dụng. Các nhà cung cấp dịch vụ AI khác qua đó có thể rút kinh nghiệm thiết kế tính năng có cảnh báo rõ ràng, minh bạch hơn.

Đồng thời người dùng cũng cần chủ động hạn chế đưa các thông tin mang tính định danh hay bí mật cá nhân lên các nền tảng AI một cách không có kiểm soát”, chuyên gia bảo mật Vũ Ngọc Sơn khuyến cáo.

Theo chuyên gia bảo mật dữ liệu, vụ việc trên cho thấy cần có những hành lang pháp lý và tiêu chuẩn an ninh mạng cho AI. Các nhà cung cấp, phát triển AI cũng cần thiết kế các hệ thống đảm bảo an ninh, tránh nguy cơ lộ lọt dữ liệu như: lộ qua lỗ hổng không tốt; lỗ hổng phần mềm khiến bị tấn công cơ sở dữ liệu; không kiểm soát tốt dẫn tới bị đầu độc, lạm dụng để trả lời các câu hỏi sai lệch, xuyên tạc.

Về phía người dùng cũng cần kiểm soát tốt việc chia sẻ thông tin cá nhân với AI, không chia sẻ thông tin nhạy cảm. Trong trường hợp thực sự cần thì nên sử dụng chế độ ẩn danh hoặc chủ động mã hóa thông tin để tránh dữ liệu được liên kết trực tiếp với cá nhân cụ thể.

Nguồn: https://tuoitre.vn/hang-ngan-cuoc-tro-chuyen-voi-chatgpt-bi-lo-tren-google-nguoi-dung-luu-y-gi-20250805152646255.htm

![[Ảnh] Thủ tướng Phạm Minh Chính chủ trì Hội nghị Hội đồng Điều phối vùng Đồng bằng sông Hồng lần thứ sáu](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/9/20/310e73a867174433b2c489ec309c9063)

![[VIDEO] 50 năm Petrovietnam: Giữ lửa di sản, kiến tạo năng lượng quốc gia](https://vphoto.vietnam.vn/thumb/402x226/vietnam/resource/IMAGE/2025/9/20/dff4ddb3d15a4076ba5f67fcdc6c7189)

Bình luận (0)