اجتمعت مجموعة من الخبراء الدوليين البارزين في بكين الأسبوع الماضي، حيث حددوا "الخطوط الحمراء" في تطوير الذكاء الاصطناعي، بما في ذلك إنشاء الأسلحة البيولوجية وتنفيذ الهجمات الإلكترونية.

وفي بيان صدر بعد أيام من الاجتماع، حذر العلماء من أن هناك حاجة إلى نهج مشترك لسلامة الذكاء الاصطناعي لمنع "المخاطر الكارثية أو حتى الوجودية التي تهدد البشرية في حياتنا".

في ذروة الحرب الباردة، ساهم التعاون العلمي والحكومي الدولي في منع وقوع كارثة نووية. ويجب على البشرية أن تتعاون مجددًا لمنع الكارثة التي قد تنشأ عن تكنولوجيا غير مسبوقة، وفقًا للبيان.

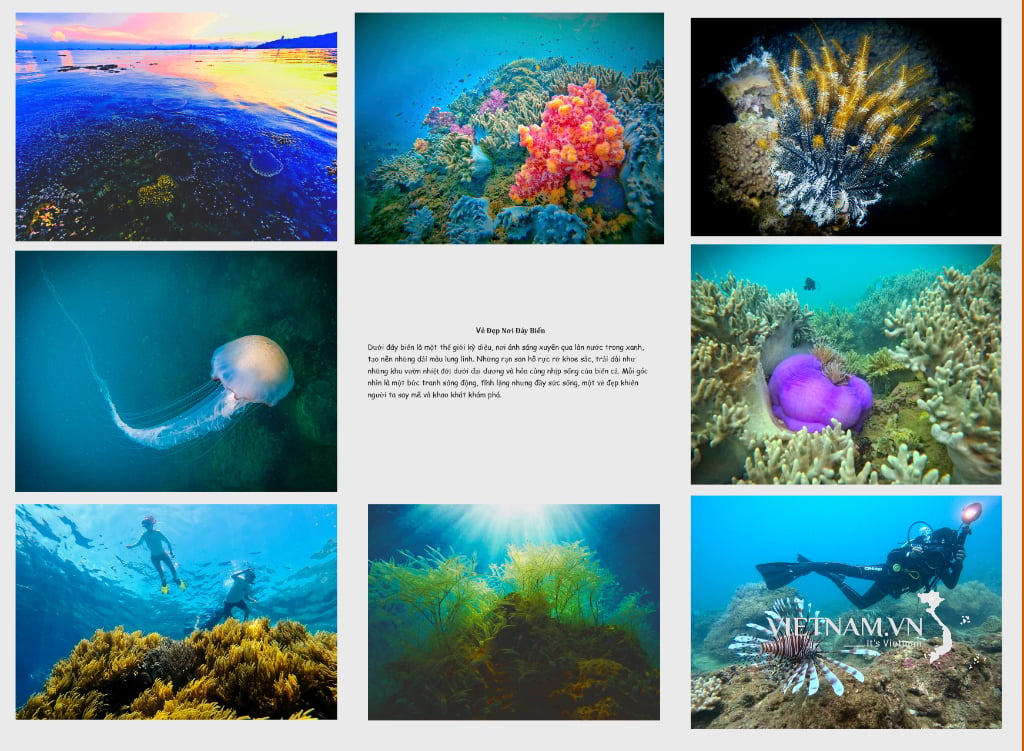

حدد الخبراء المشاركون في الحوار الدولي حول سلامة الذكاء الاصطناعي في بكين "الخطوط الحمراء" في تطوير الذكاء الاصطناعي. الصورة: فاينانشال تايمز

ومن بين الموقعين على الرسالة جيفري هينتون ويوشوا بينجيو، اللذين يوصفان في كثير من الأحيان بأنهما "آباء" الذكاء الاصطناعي؛ وستيوارت راسل، أستاذ علوم الكمبيوتر في جامعة كاليفورنيا؛ وأندرو ياو، أحد أبرز علماء الكمبيوتر في الصين.

ويأتي هذا البيان بعد الحوار الدولي حول سلامة الذكاء الاصطناعي الذي عقد في بكين الأسبوع الماضي، وهو اجتماع حضره مسؤولون من الحكومة الصينية للتعبير عن موافقتهم على المنتدى ونتائجه.

التقى الرئيس الأمريكي جو بايدن والرئيس الصيني شي جين بينغ في نوفمبر من العام الماضي، وناقشا سلامة الذكاء الاصطناعي، واتفقا على بدء حوار حول هذه القضية. كما عقدت شركات الذكاء الاصطناعي الرائدة عالميًا اجتماعات خاصة مع خبراء صينيين في هذا المجال خلال الأشهر الأخيرة.

في نوفمبر/تشرين الثاني 2023، وافقت 28 دولة، بما في ذلك الصين، وشركات الذكاء الاصطناعي الرائدة على التزام واسع النطاق بالعمل معًا لمعالجة المخاطر الوجودية الناجمة عن الذكاء الاصطناعي المتقدم في قمة سلامة الذكاء الاصطناعي التي نظمها المستشار البريطاني ريشي سوناك.

في الأسبوع الماضي، ناقش الخبراء في بكين التهديدات المرتبطة بتطوير "الذكاء العام الاصطناعي" أو أنظمة الذكاء الاصطناعي التي تعادل البشر أو تتفوق عليهم.

وقال بينجيو: "كان التركيز الأساسي للمناقشة هو الخطوط الحمراء التي لا ينبغي لأي نظام ذكاء اصطناعي قوي أن يتجاوزها والتي ينبغي للحكومات في جميع أنحاء العالم فرضها في تطوير ونشر الذكاء الاصطناعي".

ومن شأن هذه الخطوط الحمراء أن تضمن "أن لا يتمكن أي نظام ذكاء اصطناعي من تكرار نفسه أو تحسين نفسه دون موافقة ودعم بشري صريحين" أو "اتخاذ إجراءات من شأنها أن تزيد من قوته ونفوذه بشكل غير ملائم".

وأضاف العلماء أنه لا يوجد نظام "سيعزز بشكل كبير قدرة الجهات الفاعلة على تصميم أسلحة الدمار الشامل، أو انتهاك اتفاقية الأسلحة البيولوجية أو الكيميائية" أو يكون قادرًا على "تنفيذ هجمات إلكترونية تلقائيًا تؤدي إلى خسائر مالية جسيمة أو ضرر مكافئ".

هوانغ هاي (وفقا لصحيفة فاينانشال تايمز)

[إعلان 2]

مصدر

تعليق (0)