أعلنت شركة إنفيديا عن مجموعة من المنتجات الجديدة خلال مؤتمر المطورين الذي عُقد في 18 مارس، لتعزيز مكانتها في سوق الذكاء الاصطناعي. وقد ارتفع سعر سهم الشركة المصنعة للرقائق 54 ضعفًا، وتضاعفت إيراداتها بأكثر من ثلاثة أضعاف منذ أن أطلق ChatGPT سباق الذكاء الاصطناعي العالمي في أواخر عام 2022. وتُعدّ وحدات معالجة الرسومات (GPU) عالية الأداء من إنفيديا ضرورية لتدريب ونشر نماذج اللغات الكبيرة، حيث تُنفق شركات مثل مايكروسوفت وميتا مليارات الدولارات على هذه الرقائق.

أطلقت إنفيديا على شريحة الذكاء الاصطناعي من الجيل التالي اسم "بلاك ويل". ستتوفر أول شريحة من بلاك ويل، GB200، في وقت لاحق من هذا العام. تُقدم إنفيديا لعملائها شرائح أقوى لتحفيز طلبات جديدة. ولا يزال العملاء يتدافعون للحصول على شريحة H100 Hopper.

قال الرئيس التنفيذي لشركة Nvidia، جينسن هوانج، خلال الحدث: "Hopper رائع، لكننا بحاجة إلى وحدات معالجة رسومية أكبر".

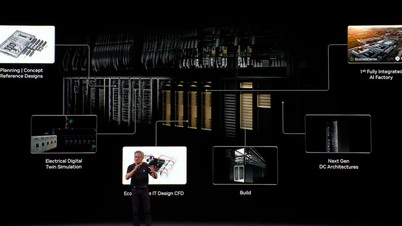

إلى جانب شريحة بلاكويل، طرحت إنفيديا أيضًا برنامج NIM الذي يُسهّل نشر الذكاء الاصطناعي. ويقول مسؤولو إنفيديا إن الشركة أصبحت أقرب إلى كونها مزوّد منصات مثل آبل ومايكروسوفت منها إلى مورد شرائح.

قال هوانغ: "بلاكويل ليس شريحة، بل اسم منصة" . ووعد نائب رئيس إنفيديا، مانوفير داس، بأن برنامج NIM سيساعد المطورين على تشغيل البرامج على أي وحدة معالجة رسومية من إنفيديا، قديمة كانت أم جديدة، للوصول إلى المزيد من المستخدمين.

بلاكويل، "خليفة" هوبر

تُحدّث إنفيديا بنية وحدة معالجة الرسومات (GPU) الخاصة بها كل عامين، مما يُتيح تحسينات جديدة في الأداء. تم تدريب العديد من نماذج الذكاء الاصطناعي التي صدرت العام الماضي على بنية هوبر، والتي ستتوفر ابتداءً من عام ٢٠٢٢.

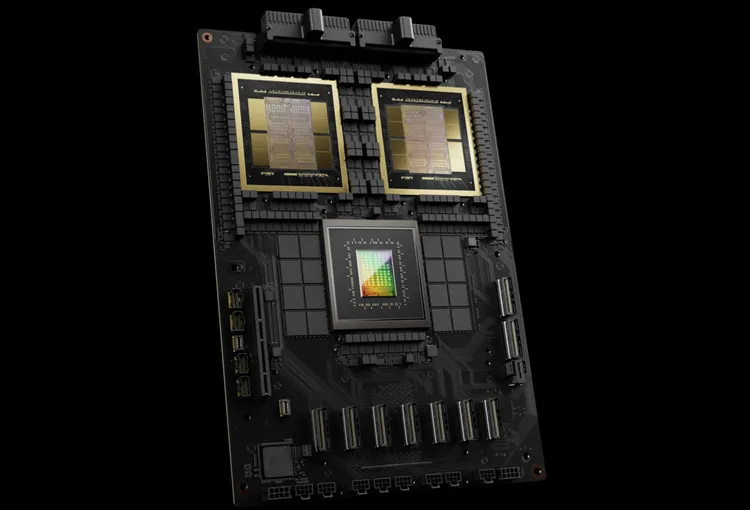

تقول شركة إنفيديا إن الرقائق القائمة على بلاكويل، مثل GB200، تُحسّن أداء شركات الذكاء الاصطناعي بشكل ملحوظ، حيث تُقدّم 20 بيتافلوبس مقارنةً بـ 4 بيتافلوبس في H100. تُمكّن هذه القدرة على المعالجة شركات الذكاء الاصطناعي من تدريب نماذج أكبر وأكثر تعقيدًا.

وحدة معالجة الرسوميات Blackwell كبيرة الحجم، وتجمع بين شريحتين مُصنّعتين بشكل منفصل في شريحة واحدة. وهي متوفرة أيضًا كخادم كامل يُسمى GB200 NVLink 2، والذي يجمع 72 وحدة معالجة رسوميات Blackwell وأجزاء أخرى من Nvidia مُصممة لتدريب نماذج الذكاء الاصطناعي.

ستوفر أمازون وجوجل ومايكروسوفت وأوراكل إمكانية الوصول إلى معالج GB200 عبر خدمات الحوسبة السحابية. يجمع معالج GB200 بين وحدتي معالجة رسوميات من طراز B200 Blackwell ووحدة معالجة مركزية من طراز Grace. وأعلنت إنفيديا أن أمازون ويب سيرفيسز (AWS) ستبني مجموعة خوادم تضم 20,000 شريحة من معالجات GB200.

يستطيع النظام تشغيل نموذج يحتوي على 27 تريليون معلمة، وهو أكبر بكثير من أكبر النماذج المتاحة حاليًا، مثل GPT-4 (1.7 تريليون معلمة). يعتقد العديد من باحثي الذكاء الاصطناعي أن النماذج الأكبر حجمًا ذات المعلمات والبيانات الأكبر قد تفتح آفاقًا جديدة.

لم تُعلن شركة إنفيديا عن أسعار معالج GB200 الجديد أو الأنظمة التي تتضمنه. يتراوح سعر معالج H100، القائم على معالج Hopper من إنفيديا، بين 25,000 و40,000 دولار أمريكي للوحدة، بينما يصل سعر النظام بأكمله إلى 200,000 دولار أمريكي، وفقًا لتقديرات المحللين.

(وفقا لشبكة CNBC)

[إعلان 2]

مصدر

![[صورة] لقطة مقربة لـ Thu Thiem الحديثة، التي تربط الحياة الجديدة بالمنطقة 1](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/6/24/d360fb27c6924b0087bf4f288c24b2f2)

![[صورة] الأمين العام تو لام يلتقي بمجموعة نواب الجمعية الوطنية الشباب](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/6/24/618b5c3b8c92431686f2217f61dbf4f6)

![[صورة] المؤتمر التاسع للحزب لدار النشر السياسية الوطنية الحقيقة](https://vphoto.vietnam.vn/thumb/1200x675/vietnam/resource/IMAGE/2025/6/24/ade0561f18954dd1a6a491bdadfa84f1)

تعليق (0)