الصورة المعقدة لروبوتات الذكاء الاصطناعي القاتلة

إن السماح للذكاء الاصطناعي بالتحكم في أنظمة الأسلحة قد يعني تحديد الأهداف ومهاجمتها وتدميرها دون تدخل بشري. وهذا يثير تساؤلات قانونية وأخلاقية خطيرة.

وأكد وزير الخارجية النمساوي ألكسندر شالينبيرج على خطورة الوضع، قائلاً: "هذه هي لحظة أوبنهايمر لجيلنا".

بدأت الروبوتات والأسلحة التي تستخدم الذكاء الاصطناعي تُستخدم على نطاق واسع في جيوش العديد من الدول. الصورة: فوربس

في الواقع، أصبح مدى "خروج المارد من القمقم" سؤالا ملحا، مع استخدام الطائرات بدون طيار والذكاء الاصطناعي على نطاق واسع من قبل الجيوش في جميع أنحاء العالم .

وقال ويلسون جونز، محلل الدفاع في شركة جلوبال داتا: "إن استخدام الطائرات بدون طيار في الصراعات الحديثة من قبل روسيا وأوكرانيا، واستخدام الطائرات بدون طيار من قبل الولايات المتحدة في عمليات الضربات المستهدفة في أفغانستان وباكستان، وكما تم الكشف عنه مؤخرًا في الشهر الماضي، كجزء من برنامج لافندر الإسرائيلي، يُظهر كيف يتم استخدام قدرات معالجة المعلومات للذكاء الاصطناعي بشكل نشط من قبل الجيوش العالمية لتعزيز قوتها الهجومية".

كشفت تحقيقات أجراها مكتب الصحافة الاستقصائية الحربية في لندن أن نظام الذكاء الاصطناعي "لافندر" التابع للجيش الإسرائيلي يتمتع بدقة 90% في تحديد هوية الأفراد المرتبطين بحماس، ما يعني أن 10% منهم ليسوا كذلك. وقد أدى ذلك إلى مقتل مدنيين أيضًا بفضل قدرات الذكاء الاصطناعي على تحديد الهوية واتخاذ القرارات.

تهديد للأمن العالمي

ويسلط استخدام الذكاء الاصطناعي بهذه الطريقة الضوء على الحاجة إلى إدارة التكنولوجيا في أنظمة الأسلحة.

"إن استخدام الذكاء الاصطناعي في أنظمة الأسلحة، وخاصة عند استخدامه للاستهداف، يثير أسئلة أساسية حول من نحن كبشر وعلاقتنا بالحرب، وبشكل أكثر تحديدًا افتراضاتنا حول كيفية استخدامنا للعنف في الصراع المسلح،" أوضح الدكتور ألكسندر بلانشارد، زميل أبحاث أول في برنامج حوكمة الذكاء الاصطناعي في معهد ستوكهولم الدولي لأبحاث السلام (SIPRI)، وهي مجموعة بحثية مستقلة تركز على الأمن العالمي، لـ Army Technology.

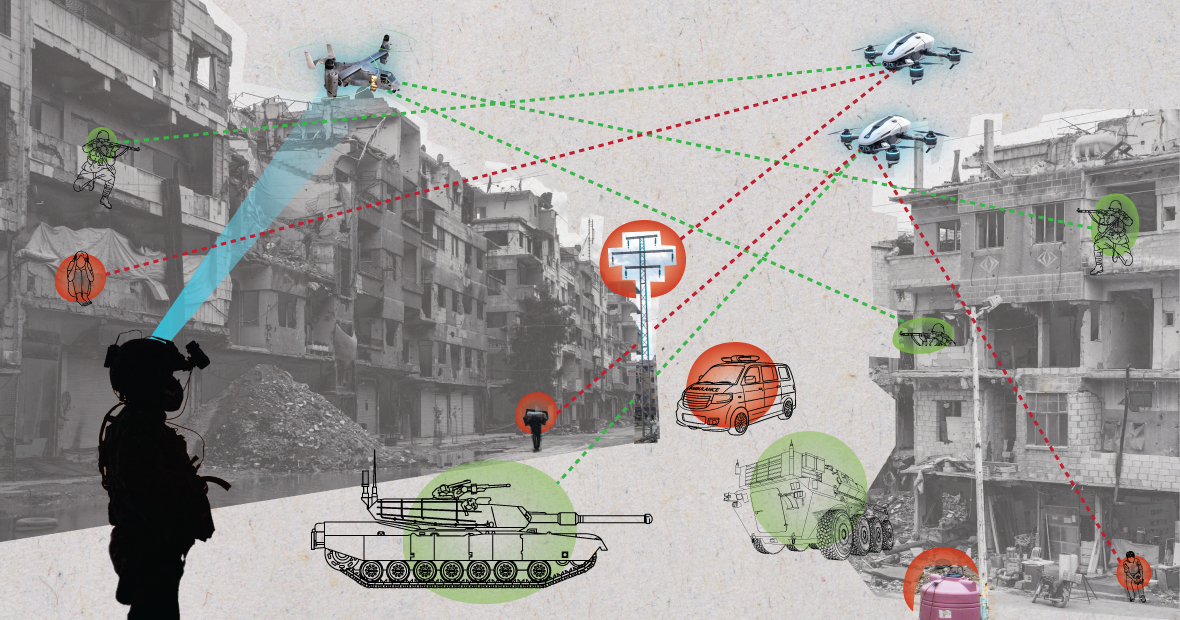

عند استخدام أنظمة الذكاء الاصطناعي في بيئات فوضوية، قد تتصرف بشكل غير متوقع وقد تفشل في تحديد الأهداف بدقة. الصورة: MES

كيف يُغيّر الذكاء الاصطناعي طريقة اختيار الجيش للأهداف وتطبيقه القوة عليها؟ تُثير هذه التغييرات بدورها مجموعةً من التساؤلات القانونية والأخلاقية والعملياتية. وتُعدّ الإنسانية أبرز المخاوف، كما أضاف الدكتور بلانشارد.

أوضح خبير معهد ستوكهولم الدولي لأبحاث السلام (SIPRI): "يشعر الكثيرون بالقلق من أن الأنظمة ذاتية التشغيل، بناءً على كيفية تصميمها واستخدامها، قد تُعرّض المدنيين وغيرهم ممن يحميهم القانون الدولي لخطر أكبر من الأذى". وأضاف: "يعود ذلك إلى أن أنظمة الذكاء الاصطناعي، وخاصةً عند استخدامها في بيئات فوضوية، قد تتصرف بشكل غير متوقع، وقد تفشل في تحديد الأهداف بدقة ومهاجمة المدنيين، أو في تحديد هوية المقاتلين غير المشاركين في القتال".

وفي تفصيله لهذه القضية، أشار محلل الدفاع في شركة جلوبال داتا، ويلسون جونز، إلى أن مسألة كيفية تحديد الذنب يمكن أن تكون موضع تساؤل.

قال جونز: "بموجب قانون الحرب الحالي، هناك مفهوم مسؤولية القيادة. وهذا يعني أن الضابط أو الجنرال أو أي قائد آخر مسؤول قانونيًا عن أفعال القوات الخاضعة لقيادته. إذا ارتكبت القوات جرائم حرب، فإن الضابط مسؤول حتى لو لم يأمر بها، ويقع عليه عبء الإثبات لإثبات بذله كل ما في وسعه لمنع جرائم الحرب".

مع أنظمة الذكاء الاصطناعي، يُعقّد هذا الأمور. هل فني تكنولوجيا المعلومات مسؤول؟ أم مصمم النظام؟ الأمر ليس واضحًا. وإذا لم يكن واضحًا، فسيُشكّل ذلك خطرًا أخلاقيًا إذا اعتقد الفاعلون أن أفعالهم لا تحميها القوانين السارية، كما أكّد جونز.

جندي أمريكي يُجري دوريةً برفقة كلب روبوت. الصورة: فوربس

اتفاقيات الحد من الأسلحة: تُقيّد وتُنظّم العديد من الاتفاقيات الدولية الرئيسية استخدامات مُعيّنة للأسلحة. فهناك حظرٌ للأسلحة الكيميائية، ومعاهداتٌ لمنع انتشار الأسلحة النووية، واتفاقيةٌ بشأن أسلحة تقليدية مُعيّنة، التي تحظر أو تُقيّد استخدام أسلحة مُحدّدة تُعتبر مُسبّبةً لمعاناةٍ غير ضرورية أو غير مُبرّرة للمُقاتلين، أو تُؤثّر على المدنيين دون تمييز.

يوضح محلل الشؤون الدفاعية ويلسون جونز: "تطلب الحد من الأسلحة النووية عقودًا من التعاون الدولي والمعاهدات اللاحقة لتطبيقها". ويضيف: "حتى في ذلك الوقت، واصلنا إجراء التجارب الجوية حتى تسعينيات القرن الماضي. وكان أحد الأسباب الرئيسية لنجاح منع الانتشار النووي هو التعاون بين الولايات المتحدة والاتحاد السوفيتي في ظل النظام العالمي ثنائي القطب. لم يعد هذا التعاون قائمًا، وأصبحت التكنولوجيا التي تُمكّن الذكاء الاصطناعي متاحةً للعديد من الدول أكثر من الطاقة النووية".

يجب أن تجمع معاهدة ملزمة جميع الأطراف المعنية على طاولة المفاوضات للموافقة على عدم استخدام أداة تزيد من قوتها العسكرية. من غير المرجح أن ينجح هذا لأن الذكاء الاصطناعي قادر على تحسين الفعالية العسكرية بتكلفة مالية ومادية ضئيلة.

التوقعات الجيوسياسية الحالية

ورغم أن البلدان في الأمم المتحدة أقرت بضرورة الاستخدام العسكري المسؤول للذكاء الاصطناعي، إلا أن هناك الكثير من العمل الذي يتعين القيام به.

قالت لورا بيترون، المحللة الرئيسية في غلوبال داتا، لموقع آرمي تكنولوجي: "في غياب إطار تنظيمي واضح، تبقى هذه المطالبات طموحة إلى حد كبير". وأضافت: "ليس من المستغرب أن تسعى بعض الدول إلى الحفاظ على سيادتها عند اتخاذ القرارات المتعلقة بالدفاع الداخلي والأمن القومي، لا سيما في ظل التوترات الجيوسياسية الحالية".

وأضافت السيدة بيترون أنه في حين أن قانون الذكاء الاصطناعي للاتحاد الأوروبي يحدد بعض المتطلبات لأنظمة الذكاء الاصطناعي، فإنه لا يتناول أنظمة الذكاء الاصطناعي للأغراض العسكرية.

أعتقد أنه على الرغم من هذا الاستبعاد، يُمثل قانون الذكاء الاصطناعي جهدًا هامًا لإنشاء إطار عمل طال انتظاره لتطبيقات الذكاء الاصطناعي، والذي قد يُؤدي إلى توحيد المعايير ذات الصلة في المستقبل. وسيكون هذا التوحيد مهمًا أيضًا للذكاء الاصطناعي في المجال العسكري.

نجوين خانه

[إعلان 2]

المصدر: https://www.congluan.vn/moi-nguy-robot-sat-thu-ai-dang-de-doa-an-ninh-toan-cau-post304170.html

تعليق (0)